Os robôs de busca do Google são rápidos em descobrir e catalogar novas páginas da Internet. Porém, um site mal desenvolvido pode apresentar alguns erros que comprometem o rastreio e indexação, por isso é importante começar uma otimização de SEO fazendo essa análise.

Ter certeza de que o Google está conseguindo rastrear as páginas e a frequência com que isso acontece é o primeiro passo das otimizações técnicas nos meus projetos de SEO. Isso porque seria uma grande perda de tempo criar conteúdos excelentes e aplicar outras técnicas on-page se os bots não estão acessando as páginas, concorda?

É por isso que eu compilei neste artigo informações importantes que vão te ajudar a entender como o rastreio acontece e como resolver os principais problemas que vejo nos sites que demoram para indexar ou que são pouco rastreados.

Como o Google rastreia os sites na Web?

O Google possui um catálogo enorme de URLs que encontra na internet. Sempre que os robôs de busca do Google identificam um novo link em uma página a sua grande listagem é atualizada. Ou seja, para que ele encontre uma nova página é preciso haver um link para ela em outra página já conhecida.

Se o seu site já tem um bom número de páginas e já é conhecido pelo Google, os links internos farão esse trabalho. Quando estamos falando de um site totalmente novo, pode ser preciso conseguir um link em algum outro site para acelerar este processo.

A partir desse catálogo de URLs do Google, as páginas já conhecidas são revisitadas com uma frequência variável para identificar atualizações e novos conteúdos.

Checklist + Soluções

Para saber se seu site está acessível e sendo rastreado normalmente verifique os pontos abaixo.

1. Confira se o seu site possui um arquivo robots.txt

Neste arquivo você irá determinar como e quais páginas do seu site serão rastreadas pelo Google. Ele pode ser gerado automaticamente pela plataforma utilizada na criação do site ou então pode ser criado manualmente.

Para verificar se seu site já possui um robots.txt verifique a URL seusite.com/robots.txt. É esta URL que o Google tenta acessar antes de rastrear qualquer outra página do site.

Se esse arquivo já existir, tenha certeza de que não há alguma URL importante sendo bloqueada.

2. Veja também a meta tag robots

Outro recurso para controlar a indexação das páginas é a meta tag robots. De forma parecida com o arquivo robots.txt, essa meta tag é lida por robôs de busca para entender as regras estabelecidas pelo desenvolvedor sobre aquela página específica.

Verifique dentro da seção <head> das páginas do seu site se existe a meta tag robots. Ela pode estar especificada como “noindex”, o que indica aos robôs de busca que aquela página não deve ser indexada.

<meta name="robots" content="noindex" />Se suas páginas possuem a tag indicando “noindex”, como no exemplo acima, é indicado mudar para “index,follow”, que são valores padrão. Dessa forma você estará indicando que a página pode ser indexada e seus links podem ser seguidos pelo robô de busca.

3. Verifique se o sitemap.xml está acessível

Este arquivo, no formato XML, lista todas as URLs do site informando alguns dados a mais como a data da última atualização, por exemplo. Além de linkar o sitemap no arquivo robots.txt, é importante que ele também esteja cadastrado no Google Search Console (na opção Sitemaps).

Através desse arquivo você vai facilitar (e quem sabe acelerar) o trabalho do Google, listando todas as páginas disponíveis para indexação. Esse arquivo é gerado automaticamente por sistemas como WordPress.

Se você não utiliza uma plataforma que já forneça esse recurso, será preciso um pouco de conhecimento em programação, já que este arquivo deve ser dinâmico, ou seja, deve estar sempre atualizado conforme novas páginas são criadas. Só indico que você crie esse arquivo manualmente, de forma estática, caso o site tenha poucas URLs e se novas páginas não vão ser criadas com frequência.

4. Certifique-se de que não existe algum bloqueio de páginas

Você pode fazer isso usando (de novo!) o Google Search Console, em Índice > Cobertura. Lá você vai encontrar possíveis problemas que o Google encontra ao rastrear as páginas do site, como redirecionamentos, erro 404, bloqueio pelo robots.txt, entre outros.

Na página de suporte ao Search Console estão listados todos os possíveis erros que aparecem nesse relatório. É uma ajuda importante quando você se depara com um erro diferente desses mais comuns e não entende exatamente por que a página não está sendo rastreada.

5. Utilize operadores de busca avançada no próprio buscador

Acesse o Google e no campo de busca digite “site:seusite.com.br” para descobrir quantas páginas do seu site estão indexadas. Porém, caso não seja exibido nenhum resultado, é porque as páginas desse domínio ainda não estão indexadas.

Caso sejam exibidas URLs do domínio pesquisado, atente-se também para o número de páginas encontradas. Se a quantidade estiver muito menor do que a real quantidade de páginas existentes, pode haver algum problema de rastreio e indexação.

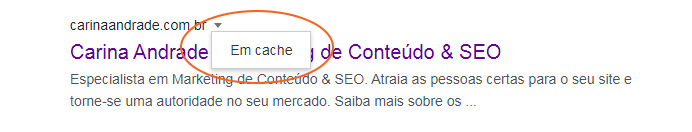

6. Olhe a data do cache do Google

Ainda nos resultados de busca (caso resultados sejam listados), clique na opção “Cache”, ao lado da URL da página.

A versão mais recente que o Google tem desta página vai abrir junto a um cabeçalho com informações na parte de cima. Nesse cabeçalho você irá encontrar a data do último rastreio do Google a esta página específica.

Se o cache é muito antigo, é sinal de que a página está sendo pouco rastreada pelos robôs de busca. E para aumentar essa taxa de rastreio indico que você crie mais conteúdo, atualize mais as suas páginas e comece a traçar uma forte estratégia de link building.

7. Confira o status code das páginas

Páginas que não foram indexadas ou que estão sendo pouco rastreadas podem apresentar algum problema de status code. Trata-se de um código de resposta do servidor (onde o site está hospedado) que é compreensível por navegadores e pelos robôs de busca.

O esperado é que o código retornado seja 200 (ou outro iniciado por 2), isso significa que a URL foi encontrada e pode ser executada. Mas fique atento a outros códigos como 301 e 302, indicando que há algum redirecionamento e o 404 quando a página não foi encontrada. O erro 500 também é bastante comum e acontece quando o servidor está fora do ar ou em manutenção. Veja aqui uma lista completa de status code e o que cada um significa

Para testar o status code das suas páginas, utilize ferramentas gratuitas como HTTP Status e Redirect Checker.

8. Formato das URLs

Se as URLs das suas páginas utilizam parâmetros, isso pode resultar em problemas de SEO em diversos aspectos. Parâmetros são informações passadas via URL e utilizadas na programação. Eles sempre aparecem após um ponto de interrogação, como no exemplo:

https://www.site.com.br?cor=cinzaQuanto mais parâmetros as páginas utilizam, maior a quantidade diferente de URLs para um mesmo conteúdo são geradas. Com uma quantidade muito grande de URLs para rastrear, o Google pode acabar não rastreando todas as suas páginas.

Se os parâmetros são importantes para navegação e organização do conteúdo do seu site (como acontece em grandes e-commerces, por exemplo), indico que você use a canonical tag para ajudar o Google a entender qual é a URL original que deve ser indexada.

9. Boas práticas e bom conteúdo

Descartando maiores problemas técnicos, a maior dica para que seu site seja mais rastreado e tenha novas URLs rapidamente indexadas no Google é seguir as diretrizes de qualidade do Google e criar conteúdo de excelência para seus usuários.

Dedicando tempo para manter o site otimizado e criar sempre novos conteúdos de ótima qualidade, a chance do seu site não ser rastreado é muito pequena. O Google busca os melhores resultados para apresentar nos resultados de busca. Se você cria um site pensando no melhor para o seu público, estará no caminho certo.

Gostou do conteúdo? Então deixa um feedback nos comentários ou me manda um e-mail 😉

Profissional de Marketing de Conteúdo & SEO trabalhando com Tecnologia e Marketing desde 2007. Bacharel em Sistemas de Informação pela Unisinos e Especialista em Gestão de Pessoas pelo Unilasalle.